Dentro dos conhecimentos de cybersecurity tenho para como escrito em pedra “os três Ps”, PPP:

Pessoa

Processo

Produto

Como pessoas, temos que entender o elemento humano, o tomador de decisão final, a que consome a tecnologia.

A decisão da pessoa é a que vale quando o Produto não teve posicionamento, quando o processo não previu. O treinamento das pessoas nunca pode ser visto como despesa; elas precisam saber o que fazer, como fazer (processo) e onde fazer (produto).

Em uma situação, após o almoço, renovei o certificado SSL de uma empresa cliente em um popular serviço de hospedagem brasileiro. Durante o atendimento, conversei com a pessoa do financeiro e lhe informei o valor que lhe seria cobrado por tal renovação. Ela me relatou a rotina de pagamento trimestral que faz para este serviço de hospedagem. Tudo certo.

Ao final do dia, a pessoa do financeiro me ligou questionando-me se um boleto de um valor expressivo que recebeu havia sido emitido em decorrência da renovação que eu havia feito. A minha resposta foi não, mas solicitei-lhe que o e-mail fosse enviado como anexo para análise.

Disse-lhe: “Arraste a mensagem para a área de trabalho e, depois, arraste o arquivo para um novo e-mail e me envie”.

Como parecia dentro do contexto, comecei a me questionar: “Será que estão cobrando mais coisas??? Será que o preço mudou???”.

Quando o e-mail chegou na minha caixa de entrada, não me contive e em pensamento já julguei o usuário, pois o assunto começava com “ENC:”. A pessoa me encaminhou o e-mail, sem seguir as orientações que eu havia dado no sentido de anexar a mensagem a um novo e-mail. Eu não tinha, então, o cabeçalho.

Durante a leitura do e-mail, o remetente parecia real. Entendo o usuário não duvidar da mensagem com base neste campo. Fiquei intrigado: “Deve ter alguém dentro do provedor de hospedagem, um Insider, que viu o cliente adicionar o serviço e mandou um boleto falso antes do real???”

Ainda lendo o e-mail, o corpo não tinha como ter contexto. Estava informando que o domínio seria desativado por falta de pagamento. Neste momento, já notifiquei a pessoa para ela não pagar o boleto, pois se tratava de golpe.

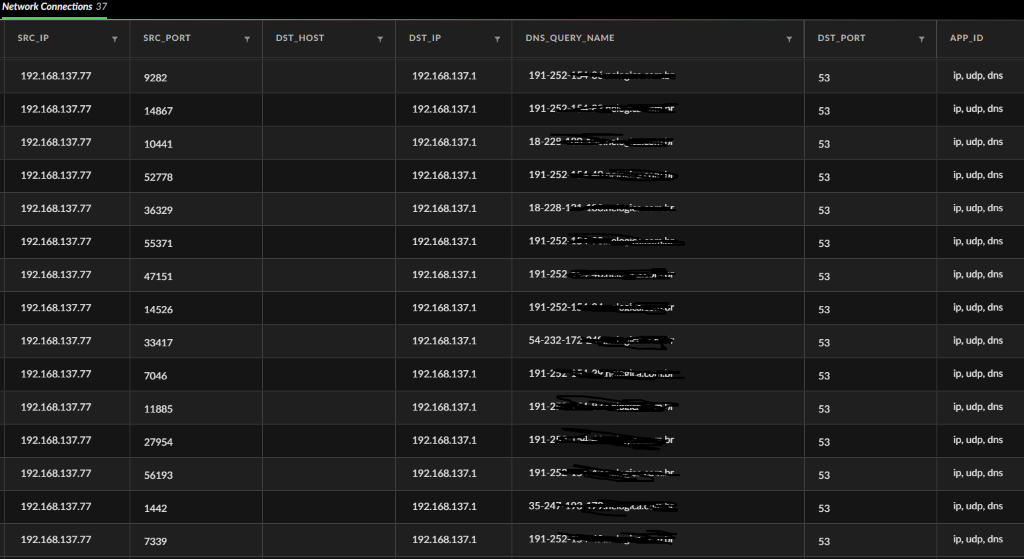

Mas, no SOC, não podemos assumir nada. Como eu não tinha o cabeçalho, acessei a ferramenta de administração do e-mail em nuvem do cliente (aqui sendo o outro “P” – Produto) e realizei o rastreio dos e-mails recebidos pela pessoa do financeiro no dia, seguindo aqui um Processo (o outro “P”).

Logo de início, estranhei o fato de ter que buscar o e-mail entre todos os recebidos naquele dia, pois ele estava no final da lista, indicando que havia sido recebido nas primeiras horas do dia, enquanto a renovação havia sido feita após o almoço. Com essa constatação, já descartei a possibilidade de se tratar de um Insider, como havia pensado anteriormente.

Ao expandir os detalhes da mensagem na tela de rastreio, notei que a ferramenta de e-mail tinha colocado a mensagem do golpe no lixo eletrônico da caixa de correio do financeiro.

No calor do momento, mais julgamentos: “COMO QUE ELA FOI CAVAR ISSO NO SPAM DELA?????”. Em instantes, porém, já o alívio: “pelo menos ela não pagou, consultou os envolvidos, foi prudente.”

Cheguei à conclusão de que o atacante quase teve sucesso por ter enviado muitos e-mails destes para os clientes da empresa de hospedagem, pois em um deles, neste caso o meu cliente, existiu uma compra real no mesmo dia; horas depois, mas no mesmo dia. Mesmo o produto do cliente – a solução de e-mail na nuvem – tendo feito corretamente a parte dele e colocando o e-mail falso no lixo eletrônico, a pessoa atravessou a linha, abrindo a mensagem e a encaminhando.

Ao encaminhar a mensagem, ao invés de anexar como eu havia solicitado, todas as imagens do e-mail falso foram carregadas. Com isso, o atacante soube que este alvo leu o e-mail e, provavelmente, o colocou em uma lista de alvos com mais chances de sucesso.

A solução oferecida pelo produto quase não fora suficiente para garantir a proteção do cliente. A linha de frente, isto é, o primeiro P – Pessoa, ignorou a proteção fornecida pelo terceiro P – Produto, o que quase gerou prejuízos à empresa.

Desta forma, não podemos nos esquecer da importância de treinar as pessoas, pois o produto por si só, por vezes, não basta.

Atuando na área desde 1999, sim sobrevivi ao bug do milênio rs.